InnoDB 事务 sharded 锁系统优化

准备

MySQL内核版本: 8.0.21

背景

latch

数据库中的 latch 和我们通常代码编程中保证并发多线程操作操作临界资源的锁意义一样,通过 latch 的中文翻译“闩”就可以理解,这是为了维护一段临界区域.lock

而 lock 则是数据库 MySQL 中在事务使用的”锁”, 锁定的对象是表或者行.

数据库内核月报 InnoDB 事务锁系统简介对 InnoDB 的事务锁系统: record lock 和 table lock 做了具体的介绍, 其中对于 record 和 table 会将所有GRANTED或者WAITING插入对应的 hash table.

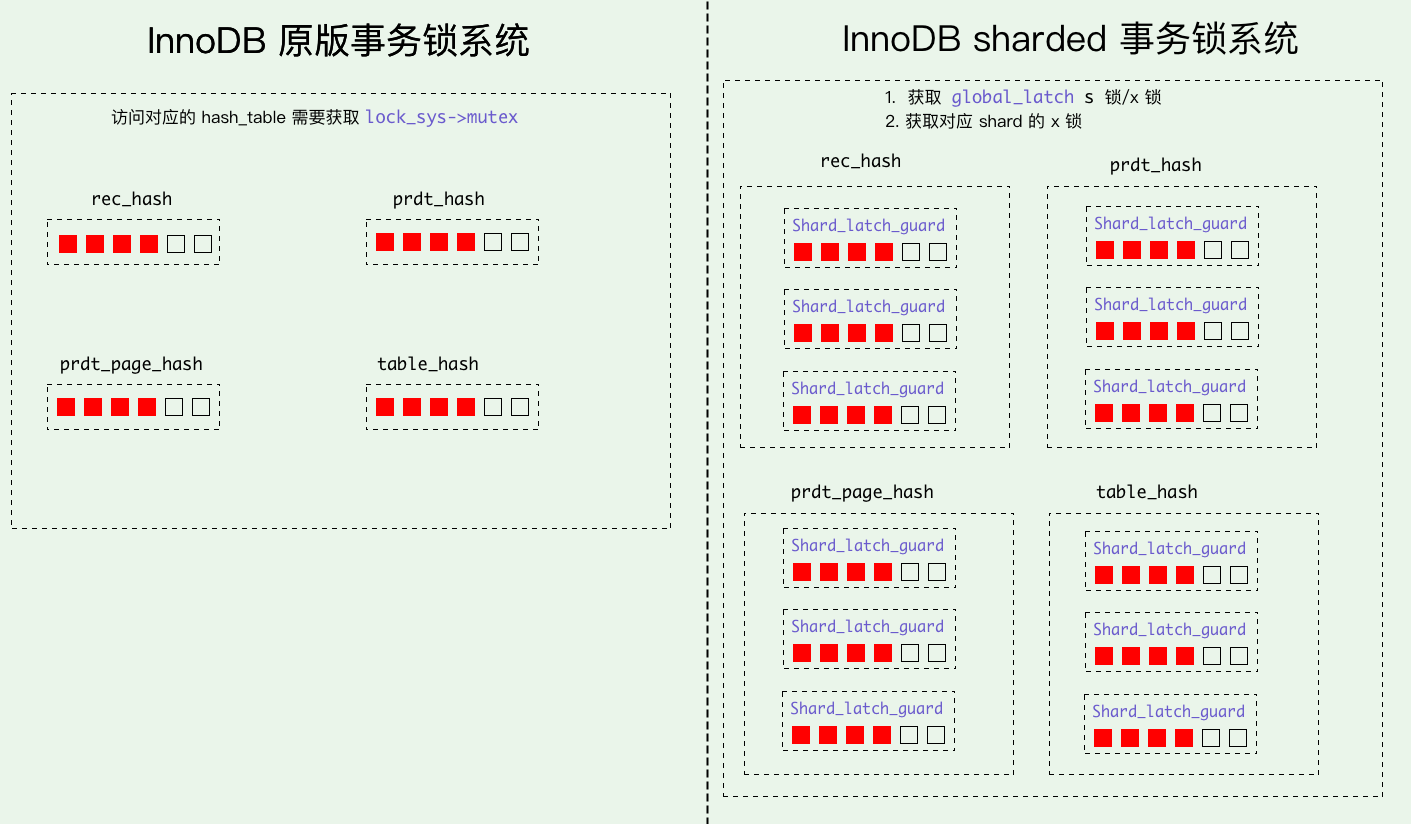

在官方 MySQL 实现中, 事务锁系统由lock_sys_t *lock_sys统一管理, 当事务尝试申请一个 lock 时,会首先尝试获取lock_sys->mutex, 在 lock 创建成功后,会插入对应类型的 hash table, 下面是官方MySQL实现中的 hash table:

1 | /** The lock system struct */ |

通过上面的简述可以理解当每一个事务需要尝试申请一个 lock 时,都需要获取这个lock_sys->mutex全局的 latch, 这对于高并发的事务处理来说是一个瓶颈. MySQL 官方在 8.0.21 版本针对这个问题使用分区 latch 来解决: worklog #10314.

lock_sys

在 8.0.21 之前的版本申请 record lock 时需要获取全局的lock_sys->mutex, 以 record lock 为例:

1 | dberr_t lock_clust_rec_modify_check_and_lock() { |

尤其当高并发事务处理,lock_sys->mutex的瓶颈会凸显. 为此官方将lock_sys->mutex的进行拆分, 引入了 3 个类型的 latch, 一个全局的global latch, 512 组table latches和 512 组page latches:

global latch (lock_sys->latches.global_latch): 一个全局读写锁, 当lock_sys全局操作时, 直接对global_latch上 X 锁, 其他操作仅需要 S 锁.table shard latches (lock_sys->latches.table_shards.mutexes): 512 个 table latches, 用来分片 table lock.page shard latches (lock_sys->latches.page_shards.mutexes): 512 个 page latches, 用来分片 record lock.

1 | [ global latch ] |

Shard_latch_guard: 针对 global latch 使用 s-latch 并对单个 shard mutex 上锁.Shard_latches_guard: 针对 global latch 使用 s-latch 并对两个 shard mutex 上锁.Global_exclusive_latch_guard: 针对 global latch 使用 x-latch.

1 | /* global_latch X 锁. */ |

在使用 shard lock 后, 申请 record lock 只需要获取对应 Page 的lock_rec_hash(page_id) % SHARDS_COUNT槽位的 mutex 即可:

1 | dberr_t lock_clust_rec_modify_check_and_lock() { |

上述代码是以 record lock 举例,使用 shard lock 后 record 申请的流程为:

针对 global_latch 使用 s-latch

获取对应 page_id 在 lock_sys 中 page_shards 的 latch:

1

lock_sys->latches.page_shards.get_mutex(page_id)

对 latch 上锁:

mutex_enter(&m_shard_mutex).

Shard_latch_guard 等实现均为 RAII 模式, 离开作用域后自动析构.

死锁检测

官方在 8.0.18 版本对死锁检测进行了优化, 将原先的死锁检测机制 MySQL 死锁检测源码分析 交给了 background thread 来处理, 具体的 Patch 链接: MySQL-8.0.18 死锁检测优化. 具体的思路是将当前事务系统的 lock 信息打一份快照, 由这份快照判断是否存在回环, 假如存在死锁即唤醒等待事务.

使用 shard lock 优化后, 因为存在多个 thread 并发更新当前 trx 的锁操作, 所以死锁检测使用Global_exclusive_latch_guard来互斥当前的 lock 操作.

总结

MySQL 官方针对 lock_sys 的 mutex 瓶颈使用了 sharded lock 的方法进行优化,这依然延续了系统设计的优化思路, 将一个 bottleneck 的全局锁拆分为 sharded, 这也符合当前多核设计下, 充分利用硬件特性以此提高并行处理能力的趋势.